摘要:刚接手不久一个B2B电子商务平台、由于产品详情页有两种不同形式的URL:有32位、也有16位,所以需要对URL进行统一规范;

那么是采用32位的:标准(长地址);

还是采用16位:(短地址)标准、当时考虑原则是两种不同形式的URL百度索引数据及两种不同形式的URL收录速度、也就是说哪URL百度索引数据多且URL收录速度快那就采用哪种URL标准;

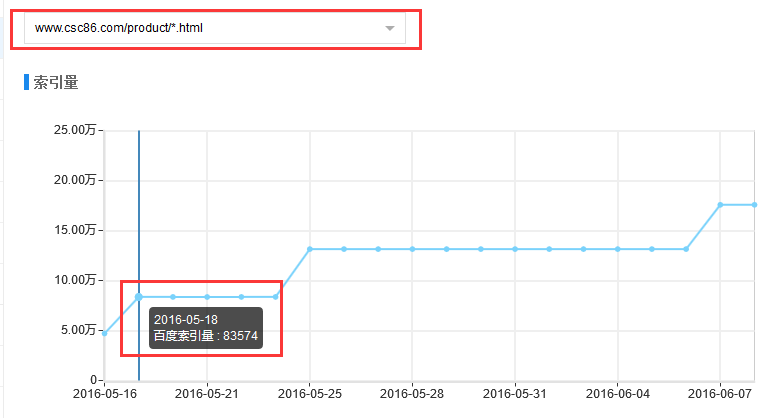

所以在百度站长工具自定义规则,分别查看两种特征页面集合的索引量数据

16位(短地址)的URL百度索引量数据

32位(长地址)的URL百度索引量数据

说明:

1、32位(长地址)的URL数据存量是16位(短地址)数据存量大概4倍

2、05-18当天16位(短地址)的URL索引量数据增加83574,而32位(长地址)URL索引量数据则增加2090

3、针对URL索引量增加没有做任何人工干预

也就是说16位(短地址)URL百度索引数据多于32位URL且短URL收录速度快,所以决定采用16位(短地址)做为产品详情URL规范;

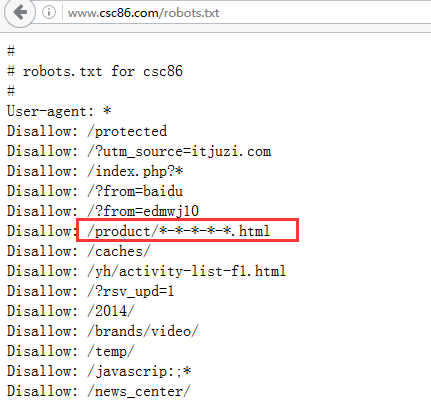

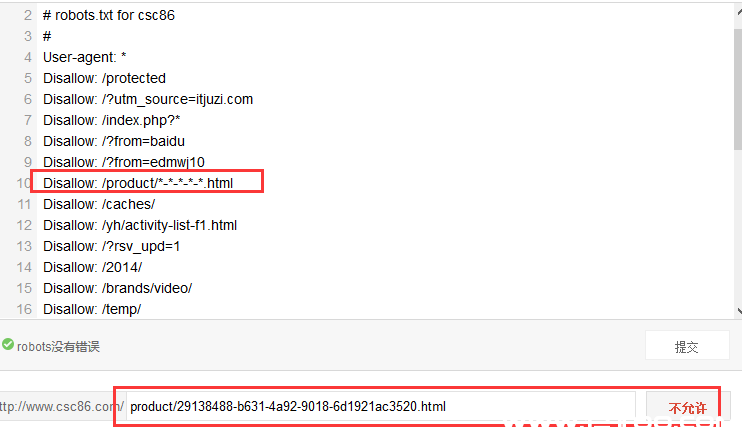

问题:05-19号针对robots文件屏蔽32位URL搜索引擎相关抓取规则

robots文件如下:

但06-07号32位URL索引量还是出现大幅增长情况

当然看到这个数据第一反应就是robots规则不对,所以对robots进行检查、但发现robots没有问题、屏蔽规则也检测正常;

在06-09号对此问题进行反馈、得到反馈的结果是百度这边处理时间较长的, 所以百度处理此类问题的反应超级慢,所以建议在处理此类问题时最好使用百度站长具检测robots 并进行强制更新。

未经裕腾智工作室授权许可任何人不得复制、转载、或以其他任何方式使用裕腾智工作室的内容。裕腾智工作室保留追责权利。文章出处:裕腾智工作室

(责任编辑:admin)