再来说一下 idgeneratror 。 按照每天业务 27700 亿来算,分词以后是 100 亿,每一个分词对应 277 行日志,这是平均数,每天 Docid 有 27700 亿个。按照每个 4 字节来计算,光是 Docid 数字将近 11TB。在这里停止了处置,采用分段区间获取降低 qps,每天的 id 重新从 0 末尾分配。我们每天 Docid 倒排索引量在2.4T。每天 27700 亿我们做起来也稍微有点发怵,我们想了一个办法,我们业务名加时间作为 key,每天id 从零末尾重新分配,这样就可以保证我每天的量不至于太高,而且分出来的 Docid 不用太大,假设太大的话,能够数据就会比较收缩。我如今建了索引是哪个业务,什么时间段,哪一天的,我这主要央求哪一个区段,假设说我央求了 1 到 100 个这个区段,在 idgeneratro 会提早预留出 1 到 100 这个空隙。

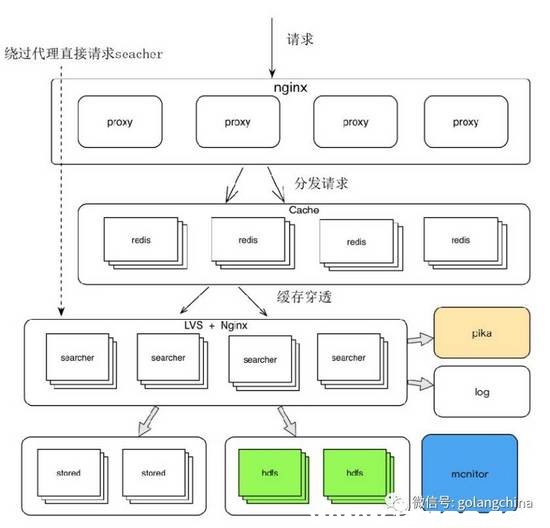

Proxy/Searcher详细设计。 Searcher中心引擎就是走四级索引外面做的事情,其中包括过滤和模糊查询等等,这些不是主干业务我没有说。从外面拿出map数据,然后再取原始数据,取完数据以后,我们有很多原始数据十分大,大约有几十兆左右,假设放在处置器前端,前面会直接卡死,我们会把原始数据比较大的业务,在页面下面给大家展现,点击查看原始数据这么一个链接,点了以后再过去央求一遍,这是一个十分复杂的架构。如图5所示。

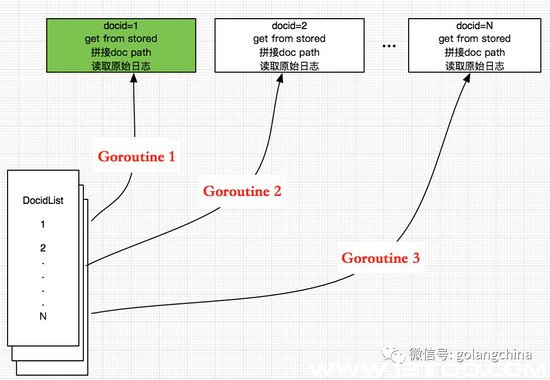

Searcher并发模型。 由于读 四级索引的时分,读 Docid 的进程如出一辙,所以我在这里用读 Docid 举例子,比如我拿到 DocidList 的数据,我会给每一个 Docid 分配一个 Goroutine ,拼接出来 doc path ,读取原始日志,然后做过滤,最后前往给前端。如图6所示。

怎样运用

第一个瓶颈。 我们团队的基础组件全是 c++,我们团队中心业务,以及在线引擎、中心引擎都是c++ 来做的。我们用到 gdb 停止调试,进程过多,用 c++ 组件一末尾想偷懒,然后编辑进C,再放到 Go 外面去。每一个读取 Docid 中,每一个文件都会去读,我们的运用顺序常常就挂,事先也没有缘由,最后我们才看到执行 CGO 的时分,我们收到一个信号,就是 signal exit,然后我们停止GDB调试,说是进程太多,由于CGO在执行的时分会新建一个M。

处置方案:用Go重新完成一遍,将组件作为http效劳,Go Client调用,做集中式处置。

第二个瓶颈。 在系统中,我们少量运用 Goroutine,子写程 panic 在主写程不能被处置掉。

处置方案:我们在通道类型外面为struct,封装正常数据和error,在主协程取取出数据,一致做处置。

阅历小结。

即使知晓很多言语,最好不要混用,要十分慎重引入其他言语的处置方案。

不要完全置信recover,它不能恢复runtime的一些panic。

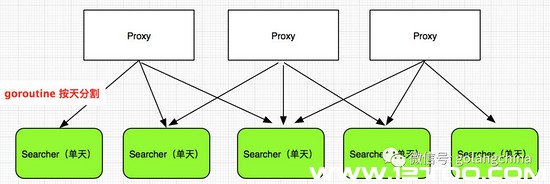

看一下我们的Proxy多天并发查询设计。 如图7所示。要做 多天查询有两种方案。第一种方案把多天查询加上,这样使我们中心查询引擎变得十分臃肿,我们还是那句话,加一个中间层。把多天变成单天,然后在Proxy 拿到一切的单天数据,就构成了多天查询。

我们还有另外一个项目,央求Poseidon的数据,我们想到两种处置方案,第一种处置方案,你在本人第三方系统外面做缓存,要不我们做缓存,我们是这样取舍。假设第三方系统外面做缓存,一切的查询,缓存只能在第三方系统外面用。假设在我们这里缓存,他们发了央求到我们这来,其他一切第三方外面都有能够能用上。我们是这样做的,首先央求 Searcher 拿到当天的数据,比如查一个月的数据,央求 Searcher 单天的数据,假设每一个Goroutine 去查一天,每一个 Goroutine 拿到 Searcher 单天数据之后,把它解出来,看一下是不是错误数据。假设是错误数据的话,直接给客户端把这条数据前往错误,并不是给客户端整个错误,由于只是这一天某一条数据有错误。而不至于我们在查询 30 天数据的时分,外面只需某一天某一条数据有错误,就直接前往给用户,我这个系统不可用。假设不是错误数据,会依据央求参数,央求参数有很多。除了这些之外,还有查询的时间,依据这个来做一个Cace Key,然后打回给前端。

我们遇到一个成绩,每一个用户会把整个索引流程都跑一遍,也就是说用户会给我们实时测试。在同一个时间之内,同一份数据在缓存时间之内不会走残缺个 readhdfs 流程。build index 顺序化,我们会有监控,假设顺序化我们会知道,顺序挂了会报警感知,但是数据错误却是未知,我们如今还没有做到这种监控。但是这个数据错误是未知的,我们修复索引就会破费少量时间,去重新写日志,跑 Docid,还要处置破绽。

我们的处置方案,第一个增加缓存时间,在可容忍错误数据时间之内,用户查询能及时发现成绩,恢复一天两天数据还可以,不至于缓存 30 天或许一、两个月,到最后错误数据会越来越多。第二个处置方案,参考 NSQ,应用 for+select 的不确定性来分馏,随机流量到 chanel 和 hdfs 做热测试。缺陷,就是开发成本相对第一种方案来说有点高。这块要留意,开发成本并不是十分高,由于 select 而只能从 chanel 拿数据。

(责任编辑:admin)